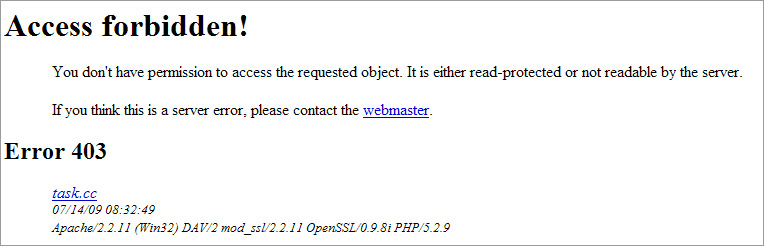

今天通過seo優化,無意間發現了這個問題,我的站點當使用http://xxx/ddd:ddd這樣的位址後,都會出現

Access Forbidden!的錯誤,可是我測試很多網站並不會存在這種情況!查過資料,大多都是userdir的解決方式,可是,我修改後並沒有解決這個問題。

我使用的是xampp 1.7.1

不知道各位有沒有有過類似情況發生?apache我又該如何配置!

今天通過seo優化,無意間發現了這個問題,我的站點當使用http://xxx/ddd:ddd這樣的位址後,都會出現

Access Forbidden!的錯誤,可是我測試很多網站並不會存在這種情況!查過資料,大多都是userdir的解決方式,可是,我修改後並沒有解決這個問題。

我使用的是xampp 1.7.1

不知道各位有沒有有過類似情況發生?apache我又該如何配置!

Re: 關於apache的設置問題

主要是因為之前無意將path_alias設置了帶有冒號的url,當時沒有發現,被google搜錄進去了,可是這個url都被引向了access forbidden!無奈想使用url_rewrite的.htaccess來設置轉址,可是發現這個access forbidden!是在.htaccess被應用之前就顯示的,修改.htaccess完全沒有作用。

無奈,弄了一下午沒弄出結果,不知道大家有沒有什麼好的建議!

Re: 關於apache的設置問題

Google 有提供工具把某些網址拿掉, 你這個剛好又已經是 forbidden 了, 直接設定進去就可以了.

http://www.google.com/webmasters/

Re: 關於apache的設置問題

啊啊... 這麼不小心啊...

是不是從LINUX搬到WINDOWS去

還有....Google 會收錄403的頁面哦 ??

Re: 關於apache的設置問題

不知道耶, 我覺得應該是不會, 不過看來確實是收錄進去了, 不然也就不會有問題了.

我之前碰到弄錯的 URL, 通常就是改 .htaccess, 把他弄成 403, 然後再去 google webmaster 把他移除, 就解決了. 新的 url 倒是不需要特別去設定, 雖然有 sitemap 可以用, 不過後來發現, google 來掃的頻率實在滿高的, 一下子就收錄進去了.

Re: 關於apache的設置問題

弄錯了URL不應該改為403, 而是用301 redirect 去正確的, 否則顯示404更好,

這樣不單對Google有效, 而且令使用者也明白. 引導回去正確頁面或即使是首頁也不會失去一個瀏覽者...

要安全點, 在robot.txt 封鎖, 那Google 一定不會index那頁面, 當然去google webmaster 移除也是個好方法

Re: 關於apache的設置問題

那 410 是不是更合適?

又, 以這個 case 來說, 應該是不需要設 robots.txt, 因為本身已經是 forbidden 了. 不然 google webmaster 是有有效期的(半年?), 所以要搭配 robots.txt 或 .htaccess 之類的

Re: 關於apache的設置問題

可能是更適合。

robots.txt 跟 forbidden 是不同意義的.

Google 怎麼處理 403 forbidden , 我不清楚, 但從主題來看, Google 是會收錄 403 forbidden (其實有點怪, 我懷疑是不是利用 site: 來搜索才看見 ?? )

不過robots.txt 設定, Google 肯定會跟從, 大部分搜索引擎都會. 大陸的就難說了

90天的有效期, 我推斷是給你機會, 讓你做事錯事時有回頭的機會. 也有可能在有效期後Google robots 會再去index 頁面, 如果還在的話就收錄, 真正是如何... 不知有沒有高人了解 ??

所以呢, 我覺得你要從Google index 拿下你的頁面, 最好的方法是 404, 或你說的 410 或 robots.txt

-----------------------

透過 robots.txt 限制

你的頁面正常 200, Google 也不會index

使用 404

Google 不會index

Re: 關於apache的設置問題

哇喔,真是不錯的解決辦法,真是很感謝dennys和Kay.L了。

說句題外話,我比較贊同Kay.L的想法,在修改google webmaster後,還是希望這個access forbidden通過301轉向正確的url,而不失去任何一個流覽者,可是我就奇怪在這個環節上:

這個帶有:冒號的位址,是顯示這樣的access forbidden,

如何設置.htaccess都無用。

而在很多站點,我看到:冒號的url都是被轉到404或者是首頁去了,如果是這樣,就很容易用上.htaccess的[R,301]了

Re: 關於apache的設置問題

xampp\apache\error\include\top.htm

編輯這檔案, 用HTML REDIRECT: